Umani e artificiali (2)

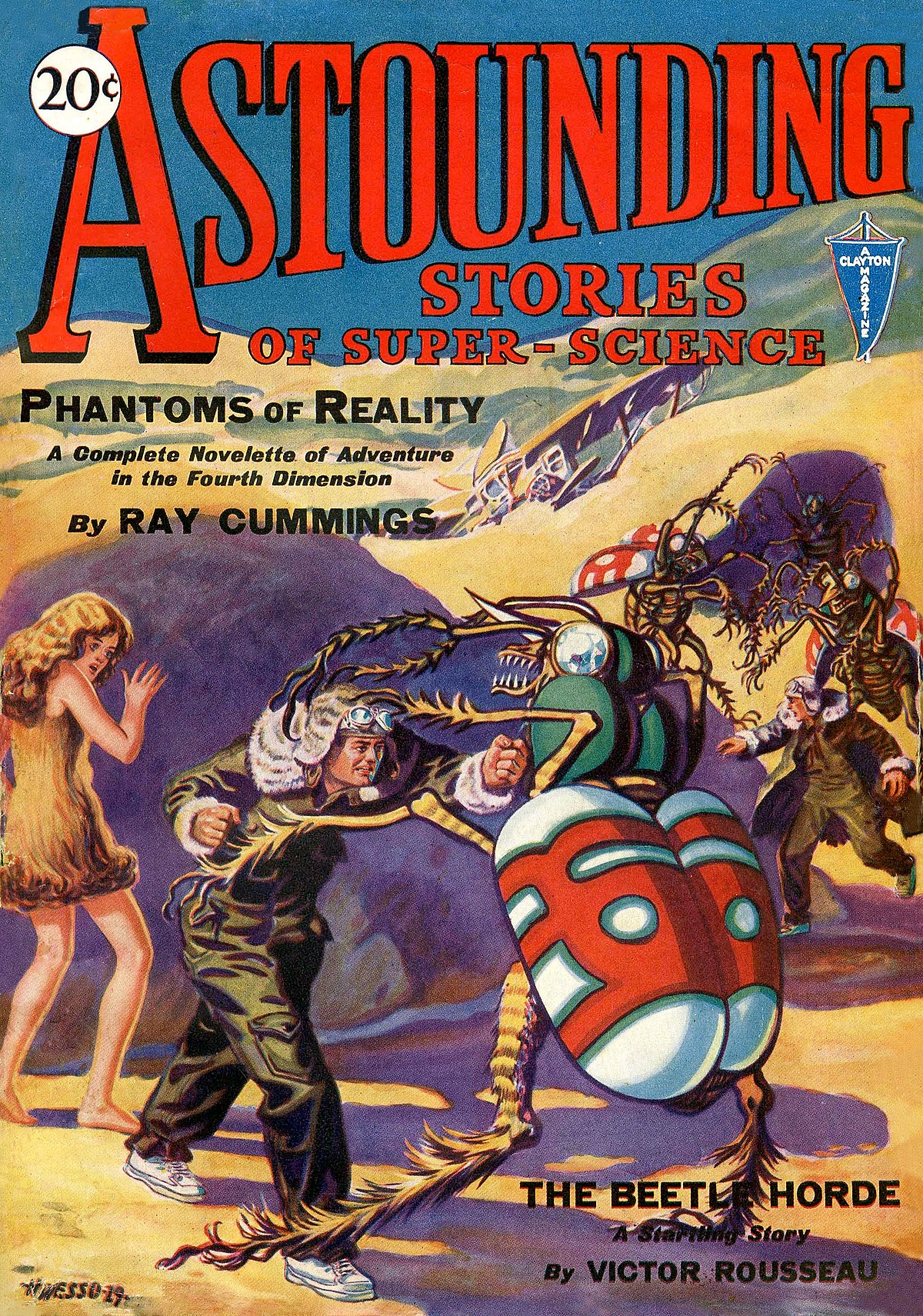

Seconda e conclusiva parte dello sbobinamento con inserti e riflessioni – vieppiù nostre – ma in realtà di vario tipo, dimensione e provenienza – si scherza lo sapete – dall’intervento della Professoressa Paola Inverardi sull’etica delle macchine al convegno di Rovereto dell’ottobre scorso. La prima parte del nostro articolo si concludeva con l’introduzione da parte della relatrice di una riflessione sul cosiddetto “dilemma del carrello”, ovvero quella particolare condizione ipotetica in cui una macchina deve, per così dire, prendere una decisione di tipo etico per fare il “minor danno possibile” agli esseri umani nel caso di un possibile e purtroppo inevitabile incidente. Lo scenario evocato dalla studiosa ci porta inevitabilmente, prima di proseguire “nell’esame” della conferenza della scienziata dell’Università dell’Aquila, a prendere visione delle uniche leggi “morali” e pratiche mai enunciate sino ad oggi, in campo scientifico, anzi meglio, fantascientifico, sul tema. Si tratta, come avrete certamente già capito, delle tre leggi della robotica di Isaac Asimov. Una invenzione davvero eccellente, nata – narrano le leggende – dalla fantasia dello scrittore e scienziato russo attorno agli anni ’40 del secolo scorso, nel corso di lunghe chiacchierate con l’omologo scienziato e scrittore americano John Campbell, curatore assieme ad Asimov della celeberrima rivista di fantascienza “Astounding stories”.

Seconda e conclusiva parte dello sbobinamento con inserti e riflessioni – vieppiù nostre – ma in realtà di vario tipo, dimensione e provenienza – si scherza lo sapete – dall’intervento della Professoressa Paola Inverardi sull’etica delle macchine al convegno di Rovereto dell’ottobre scorso. La prima parte del nostro articolo si concludeva con l’introduzione da parte della relatrice di una riflessione sul cosiddetto “dilemma del carrello”, ovvero quella particolare condizione ipotetica in cui una macchina deve, per così dire, prendere una decisione di tipo etico per fare il “minor danno possibile” agli esseri umani nel caso di un possibile e purtroppo inevitabile incidente. Lo scenario evocato dalla studiosa ci porta inevitabilmente, prima di proseguire “nell’esame” della conferenza della scienziata dell’Università dell’Aquila, a prendere visione delle uniche leggi “morali” e pratiche mai enunciate sino ad oggi, in campo scientifico, anzi meglio, fantascientifico, sul tema. Si tratta, come avrete certamente già capito, delle tre leggi della robotica di Isaac Asimov. Una invenzione davvero eccellente, nata – narrano le leggende – dalla fantasia dello scrittore e scienziato russo attorno agli anni ’40 del secolo scorso, nel corso di lunghe chiacchierate con l’omologo scienziato e scrittore americano John Campbell, curatore assieme ad Asimov della celeberrima rivista di fantascienza “Astounding stories”.

Le tre leggi della robotica inventate da Asimov, grande scrittore di fantascienza ma anche biochimico con regolare laurea conseguita alla Columbia University di New York, definiscono tre fondamentali principi a cui, secondo Asimov, nessuna macchina senziente, ovvero nessuna AI – intelligenza artificiale – può sottrarsi, anzi deve obbligatoriamente attenersi:

1) A robot may not injure a human being or, through inaction, allow a human being to come to harm.

Un robot non può recar danno a un essere umano né può permettere che, a causa del proprio mancato intervento, un essere umano riceva danno.

2) A robot must obey any orders given to it by human beings, except where such orders would conflict with the First Law.

Un robot deve obbedire agli ordini impartiti dagli esseri umani, purché tali ordini non contravvengano alla Prima Legge.

3) A robot must protect its own existence as long as such protection does not conflict with the First or Second Law.

Un robot deve proteggere la propria esistenza, purché questa autodifesa non contrasti con la Prima o con la Seconda Legge.

Tre leggi, tre principi, che sanciscono i fondamenti assoluti dell’attività di tutte le macchine intelligenti su questo pianeta o meglio – se fossero vere e non fantasiose – sancirebbero l’attività delle intelligenze artificiali operanti sul nostro pianeta. Tre regole eccellenti che definiscono altrettanti elementi fondamentali dell’operato dei robot in relazione agli esseri umani: la sicurezza, la prudenza, ma soprattutto l’essere al servizio – questa la parte a nostro avviso più importante delle leggi e della loro applicazione – di tutti gli esseri umani. Ebbene queste leggi – fantasiose – in realtà sono state e sono tuttora principi ispiratori per gli scienziati che si occupano del delicato tema della robotica e delle questioni legate ai principi etici dell’intelligenza artificiale, al punto che proprio a quelle tre leggi si sono ispirati due scienziati contemporanei per proporre una serie di “loro” leggi da introdurre ed applicare proprio nel campo della costruzione e messa in opera di apparati tecnologici dotati di intelligenza, cioè tutte le macchine di cui ci serviamo ogni attimo della nostra esistenza. Ma andiamo a leggere cosa ci racconta sul tema l’ingegnere informatico Federico Cabitza nel suo ultimo libro “L’intelligenza artificiale. L’uso delle nuove macchine”:

… un approccio che possiamo definire come ethical “in” design, cioè etico relativamente alle pratiche di

progettazione. Questo approccio non riguarda tanto gli algoritmi quanto le abitudini e la dimensione valoriale di tecnici e progettisti, perché richiede loro di assumere un atteggiamento riflessivo, critico e responsabile (insieme ai loro committenti e datori di lavoro) nelle diverse fasi del ciclo di vita dei prodotti e sistemi AI che contribuiscono a creare (e, rispettivamente, a adottare e commercializzare), comprese le fasi di analisi, progettazione e validazione. Infatti essere etici “nel” design, concretamente, significa anche adottare precisi standard internazionali e insiemi di procedure di valutazione e validazione, quali quelle volte a valutare i rischi connessi a certe metodologie di raccolta dati (ad esempio il rischio di sottorappresentare alcune minoranze, o di discriminare soggetti per genere ed etnia); con certe architetture software e hardware (ad esempio per quanto riguarda, rispettivamente, la vulnerabilità ad attacchi esterni oppure un’eccessiva impronta ecologica); o funzioni (ad esempio per quanto riguarda la sorveglianza, il filtraggio dei contenuti o la generazione di contenuti sintetici ad alto realismo).

In questa stessa direzione mi sembrano andare le recenti proposte di Frank Pasquale (2021), che propone quattro “nuove leggi della robotica” con l’intento di aggiornare quelle di Asimov; e di Francesco Varanini (2020), che invece propone cinque antileggi, cioè leggi che è moralmente giusto trasgredire, nel nostro rapporto con la tecnologia. In entrambi i casi le leggi di cui parlano Pasquale e Varanini sono chiaramente rivolte agli esseri umani, e soprattutto a coloro che creano, controllano e usano macchine dotate di intelligenza artificiale, piuttosto che ai sistemi stessi che questi possano realizzare e adottare.

Non oggi e non qui, ma Vi promettiamo un ampio articolo sulle “nuove leggi per la robotica” proposte dai due scienziati italiani e di cui ci parla l’ing. Cabitza in questo estratto dal suo ultimo saggio. Qui ed ora – hic et nunc direbbe Nathan Never – andiamo invece a vedere cosa ne pensa la professoressa Inverardi completando la lettura del suo intervento dell’ottobre scorso al Festival di Rovereto

C’è stato un esperimento molto interessante, il primo esperimento di filosofia sperimentale, della moral machine. Si aveva l’intenzione di capire se poteva esistere una etica universale che le macchine a guida autonoma potessero avere e adottare. Sono stati posti quesiti su temi come quelli del “dilemma del carrello” ad un campione statistico che rappresentava l’intera popolazione mondiale, circa 40 milioni di risposte. L’intento era quello di cercare di capire se emergessero tendenze universali.

La risposta fu: nessuna tendenza comune. Le società occidentali sono individualiste e in un dilemma di questo tipo mettono in salvo i giovani. Le società orientali salvano i vecchi e uccidono i giovani perché sono filosofie nelle quali l’anziano è portatore di conoscenza e il valore della cultura della conoscenza è più prezioso della vita del giovane.

Ovviamente si tratta solo di una speculazione scientifica statistica teorica. Solo per ribadire quanto siano dibattuti e difficili questo tipo di problemi etici. Il fatto che ci fosse bisogno di un approccio etico nella costruzione delle macchine è stato riaffermato in Europa da vari comitati: deve essere inserito il principio della cosiddetta “human dignity” cioè la dignità dell’uomo che ogni sistema deve preservare e di cui deve tenere conto. Quindi il concetto è di preservare quelle che sono le scelte individuali morali che caratterizzano l’uomo.

Eppure in una società digitale dove la relazione tra i cittadini e le macchine non è paritaria appare piuttosto ovvio che i valori morali come individualità e responsabilità siano a rischio. Se c’è un sistema che decide per me, faccio un esempio, che ci assegna il posto in autobus automaticamente; ci sentiremmo deresponsabilizzati, e in qualche modo, se anche salisse qualcuno che ha più bisogno di noi di sedersi, il fatto che qualcun altro abbia assegnato i posti, ci farebbe sentire liberi dall’obbligo morale che altrimenti – forse – potremmo avvertire con maggiore urgenza. Dunque quali sono le cose che il sistema autonomo può decidere e che cosa non può fare? Abbiamo trovato molto efficace la definizione di etica digitale che ha dato Floridi , l’etica digitale è divisa in in due parti: hard ethics (le scelte morali dettate dalle leggi o dalle convenzioni stabilite), soft ethics (quella parte delle decisioni morali che invece sono lasciate all’individuo che naturalmente non violano l’hard ethics ma non sono nemmeno normate dall’hard ethics). Si tratta di scelte che non possono essere normate perché fanno parte di quella sfera delle libertà individuali che ognuno di noi ha diritto di esercitare nel modo più appropriato a quelle che sono le sue convinzioni etiche.

Il nostro approccio scientifico nel realizzare i sistemi autonomi è stato quello di considerare che gli stessi sistemi debbano implementare l’hard ethics e quindi debbano decidere autonomamente su tutto quello che è normato. Quel tipo di scelte possono essere fatte in modo autonomo dalle AI. Ma tutte le altre decisioni che invece rientrano nel campo delle scelte individuali devono poter essere negoziate con l’utente.

Vi faccio questo esempio. Siamo in un parcheggio in un grande centro commerciale e ci sono due veicoli a guida autonoma che sono ovviamente connessi e possono comunicare fra loro, ognuno ha un passeggero a bordo e questi due veicoli stanno competendo per lo stesso spazio di parcheggio. Il passeggero di una delle due vetture ha problemi di salute. I due veicoli sono stati affittati quindi sono multi user, e hanno, ovviamente, un algoritmo di decisione di default che è quello della macchina e che agirà su tutte le decisioni che deve prendere la macchina. Le macchine cercano un parcheggio e quella che si trova più vicino al parcheggio ci si mette. Sembra una soluzione abbastanza ragionevole. A questo punto supponiamo che comunicando con le due macchine il passeggero che sta sulla macchina B riceva l’ informazione che il passeggero sulla macchina A abbia problemi di salute. Se il passeggero che sta nella macchina B dovesse seguire la sua etica individuale lascerebbe il posto al passeggero che sta nella macchina A. Questo non vuol dire che ci sia una legge che dice di farlo, dipende solo da chi c’è seduto nella macchina B, si tratta di scelte etiche personali.

Si tratta di un esempio che dimostra varie cose. La privacy, il dato personale, può essere reso pubblico, quando noi pensiamo che questa informazione possa essere utile. Cioè possa effettivamente indurre un comportamento diverso nella società nella quale ci muoviamo. Lo facciamo tutti, “in automatico”, ad esempio quando mettiamo sulla nostra auto il cartello baby onboard, bambino a bordo; oppure il cartello disabili, che

dice che ho un accesso e un diritto particolare allo stesso accesso al parcheggio; o ancora con la P dei principianti alla guida, o esibendo un fiocchetto rosa – in Inghilterra – per dire che sono incinta. La privacy personale è connessa all’etica. La rendo pubblica, divulgo a tutti questo pezzo di informazione, quando penso che possa essere utile. La seconda cosa che ci mostra l’esempio del parcheggio, è che gli individui hanno etiche differenti. L’utente nell’auto potrebbe essere sensibile a questo pezzo di informazione oppure no. Significa mettere gli umani al centro. Vuol dire progettare dei sistemi che possano accogliere le preferenze di chi li utilizza (customizzati). Sistemi che ammettano la possibilità di essere stati progettati perché questo possa accadere. Dal punto di vista tecnico questa cosa richiede un approccio architetturale. Qualcosa che si può fare e che preveda che: l’etica soft coesista con l’etica hard. Gli utenti possono avere preferenze etiche diverse – quindi soft ethics molteplici e differenti – ad ogni sistema viene invece associata una e una sola hard ethics. Il sistema dovrà essere progettato – ad esempio – per soddisfare la norma del gdpr (hard ethics). Mentre invece lo stesso sistema deve poter interagire con l’utente e quindi arrivare a fare qualche tipo di accordo in modo automatico su scelte differenti (soft ethics). Il sistema autonomo deve essere programmato in modo flessibile. Deve essere programmato per permettere la rappresentazione delle soft ethics che rappresentano le attitudini morali “diverse” di ciascun individuo. e deve anche essere programmato per essere aderente a quelle che sono le norme per poter esprimere l’etica in modo automatico attraverso un software che permetta di interagire col sistema in modo personalizzato rispetto alla sua etica.

Questo è quello che noi cerchiamo di costruire. Un lavoro che non si fa solo con gli informatici si fa con dei team multidisciplinari. Abbiamo bisogno di tante discipline. In particolare nel gruppo che lavora con me ci sono: filosofi, sociologi, psicologi, oltre agli ingegneri del software.

Bisogna che aumenti la consapevolezza negli utenti. Le persone non devono dare per scontato che se il sistema è fatto così, sia immutabile. Deve emergere l’esigenza che ci saranno campi di ricerca e mercati diversi, per la realizzazione di soluzioni alternative. Serve, veramente, l’esperienza e il sapere di tutti, per cercare di capire quali siano i valori intorno ai quali costruire la nostra nuova società digitale.

Insomma per concludere evocando ancora una volta un passaggio estratto dall’ultimo libro di Federico Cabitza che abbiamo citato più volte in questi nostri due ultimi articoli sull’etica delle macchine: non importa quanto sia intelligente la macchina o quanto sia sofisticata la sua programmazione – anche e soprattutto quando riguarda le questioni dell’etica e della morale – conta più di tutto: la trasparenza. L’uso che si fa di questi apparati e soprattutto chi c’è dietro e perché essi siano stati progettati in quel modo.

All’idea di una AI come possibile agente morale (e moralizzatore) ritengo sia più utile affiancare l’idea di AI che suggerisce Kate Crawford (2021), e cioè quella di “un’infrastruttura, un’industria, una forma di esercizio del potere e un modo di vedere”, cioè una tecnologia nel senso più ampio; quindi non qualcosa da intendersi come singolo strumento o agente identitario (“la AI fa”), ma piuttosto come un “complesso di relazioni sociali – un intreccio di strumentalità” (WATSON, 1998), e quindi una forma di esercizio di potere e di dominio, un “registro di potere” (CRAWFORD, 2021), attraverso cui “qualcuno fa”. In questa direzione va anche la quarta nuova legge proposta da Pasquale (2021) che in qualche modo suggella tutte le precedenti: “I sistemi robotici e l’AI devono sempre indicare l’identità dei loro creatori, controllori e proprietari”; insomma di chi sta dietro di loro, in modo tale che sia possibile farsi una serie di domande: quali sono i loro interessi e le loro finalità (li possiamo ancora chiamare teloi, come si diceva sopra); nell’interesse di chi propongono e promuovono una certa forma di automazione; qual è il vantaggio che ne può derivare per la maggior parte delle persone (si ricordi a riguardo la definizione di Aristotele di macchina). In questi termini, è meno importante chiedersi se una AI sia buona o equa, quanto piuttosto quali forme di potere essa amplifichi, riproduca o abiliti; “quali cambiamenti di potere economico e politico potrebbero derivare dall’uso su larga scala di questi sistemi”